Découvrez les risques potentiels liés aux conversations privées avec les assistants IA et une faille de sécurité qui permet de déchiffrer les réponses avec précision.

Les risques potentiels des conversations avec les IA

Il est crucial de prendre conscience des risques potentiels associés à nos conversations privées avec les assistants IA tels que ChatGPT. Même si nous pensons que nos échanges sont sécurisés et cryptés, des chercheurs en cybersécurité ont découvert une faille qui permet de déchiffrer les réponses des IA avec une précision étonnante.

( Source: Korben )

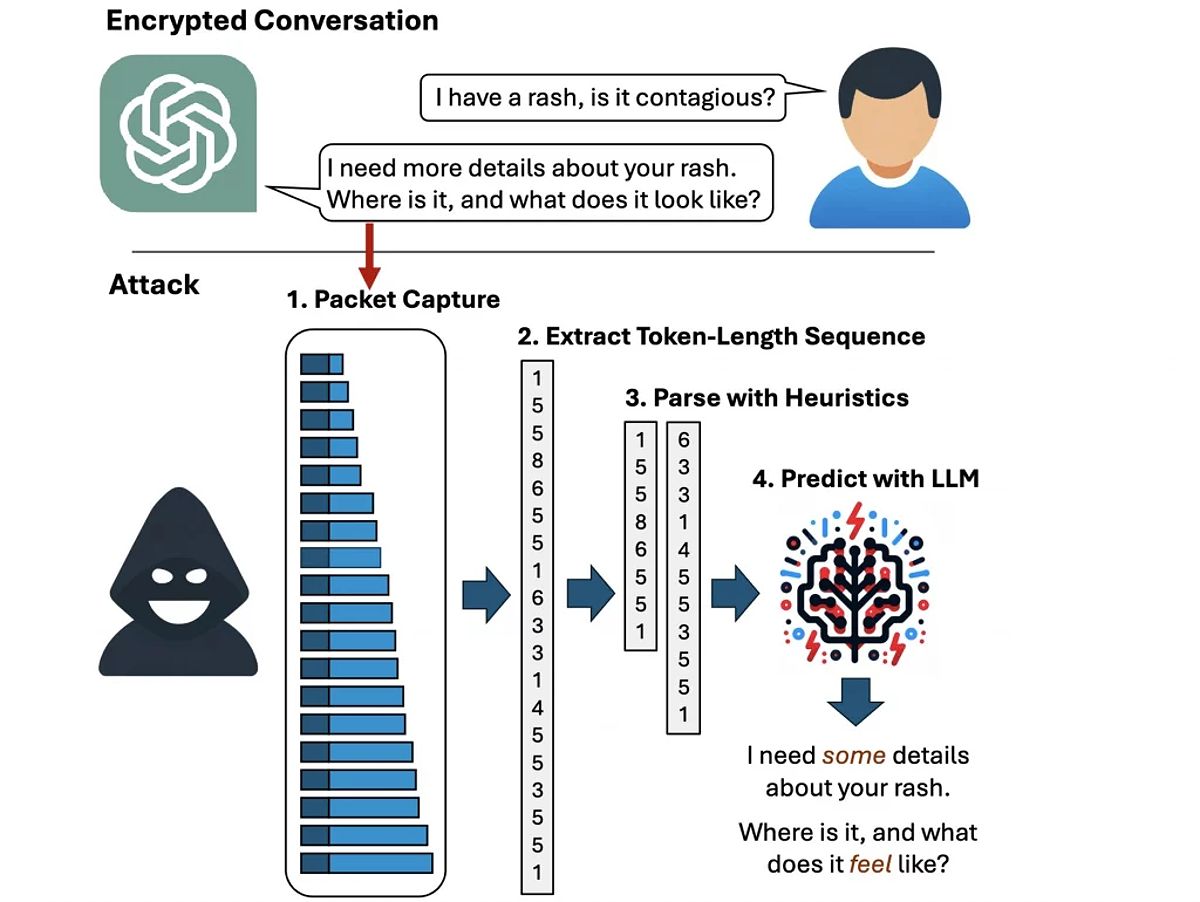

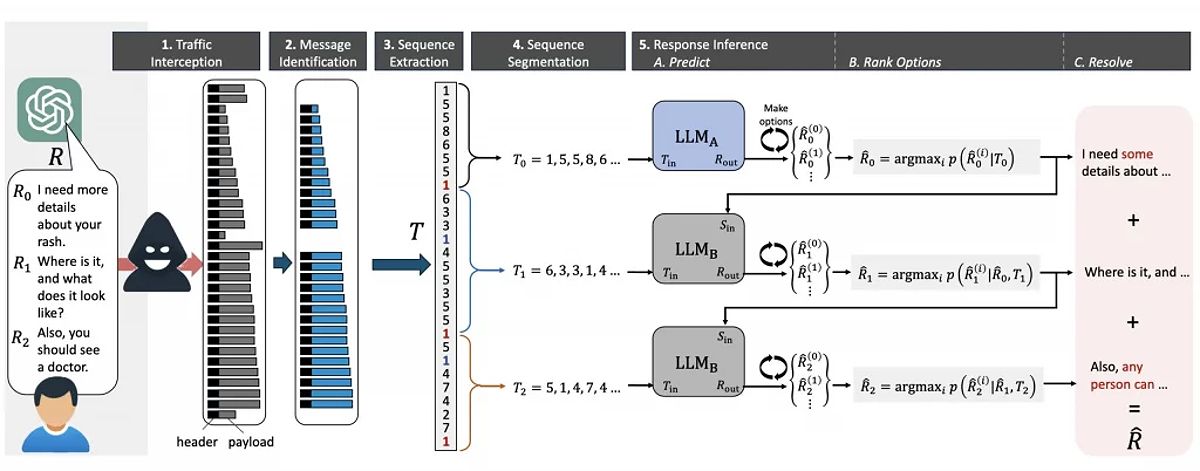

Cette vulnérabilité repose sur l’exploitation d’un canal auxiliaire, présent dans la plupart des IA, à l’exception de Google Gemini. Grâce à ce canal et à des modèles de langage spécialement entraînés, un hacker peut intercepter et deviner le sujet de 55% des réponses avec une précision remarquable. Dans 29% des cas, le hacker peut même reproduire les réponses mot pour mot. Cela peut être particulièrement inquiétant lorsqu’il s’agit de sujets sensibles tels que la santé, les relations amoureuses ou le travail.

La faille de sécurité dans les conversations avec les IA

La faille de sécurité découle de l’utilisation de ‘tokens’ par les IA pour générer leurs réponses. Ces ‘tokens’ sont essentiellement des mots codés compris uniquement par les IA. Le problème réside dans le fait que les IA envoient souvent ces ‘tokens’ au fur et à mesure de la création de leur réponse, créant ainsi un canal auxiliaire qui fuite des informations sur la longueur et la séquence des ‘tokens’. Les chercheurs appellent cela la ‘séquence de longueurs de tokens’.

Un canal auxiliaire est un moyen détourné d’obtenir des informations secrètes à partir de signaux physiques apparemment anodins tels que la consommation électrique, le temps de traitement, le son, la lumière ou les ondes. En analysant ces signaux, des hackers peuvent reconstituer des données sensibles telles que des mots de passe ou des clés de chiffrement.

Il est important de noter que les hackers doivent avoir accès au trafic réseau des victimes pour exploiter cette faille. Cependant, cela peut être facilement réalisé sur un réseau Wi-Fi public ou même au travail. Il est donc crucial de ne pas accorder une confiance aveugle au chiffrement de nos conversations avec les IA.

La vigilance nécessaire dans les conversations avec les IA

Il est recommandé d’être vigilant quant aux informations que nous partageons avec les assistants IA. Même si des mesures de sécurité sont mises en place par des entreprises telles que Microsoft et OpenAI, il y a toujours des individus malveillants qui trouvent des failles auxquelles personne n’avait pensé. La récente découverte de la ‘séquence de longueurs de tokens’ en est la preuve.

Il est donc essentiel de prendre soin de nos données personnelles et de réfléchir à deux fois avant de partager des informations sensibles avec les ChatGPT et autres assistants IA. La confidentialité de nos conversations n’est pas garantie à 100%.

Il est préférable de rester conscient des risques potentiels et de prendre des mesures supplémentaires pour protéger notre vie privée. Si vous souhaitez en savoir plus sur cette faille de sécurité, je vous invite à consulter l’article détaillé d’Ars Technica.

Protéger nos données et notre confidentialité en ligne

N’oublions pas de protéger nos données et de rester vigilants face aux nouvelles vulnérabilités qui pourraient compromettre notre confidentialité en ligne. Il est essentiel de prendre conscience des risques potentiels et de prendre des mesures pour protéger notre vie privée.

Il est recommandé d’être vigilant quant aux informations que nous confions aux assistants IA. Même si les entreprises telles que Microsoft et OpenAI mettent en place des mesures de sécurité, il y a toujours des individus malveillants qui trouvent des failles auxquelles personne n’avait pensé. Cette récente découverte de la ‘séquence de longueurs de tokens’ en est la preuve.

Il est donc essentiel de prendre soin de nos données personnelles et de réfléchir à deux fois avant de partager des informations sensibles avec les ChatGPT et autres assistants IA. La confidentialité de nos conversations n’est pas garantie à 100%.

Il est préférable de rester conscient des risques potentiels et de prendre des mesures supplémentaires pour protéger notre vie privée. Si vous souhaitez en savoir plus sur cette faille de sécurité, je vous invite à consulter l’article détaillé d’Ars Technica.

No Responses